Élaboration et validation d'une grille d'évaluation

des simulations éducatives

Mohamed Droui, Abdelkrim El Hajjami, Abdelouahab Benali Amjoud

Résumé

Cet article se propose comme objectif général d'élaborer et valider une grille d'évaluation et d'analyse des simulations éducatives. Après avoir défini le concept de la simulation éducative et les apports de son usage en enseignement des sciences et après avoir traité les différents travaux de recherche concernant l'élaboration des critères de qualité des simulations abordés, nous proposons une grille susceptible d'aider les enseignants à choisir la simulation adéquate pour une activité d'apprentissage qu'ils souhaitent entamer avec leurs élèves. La grille que nous avons conçue et validée, est destinée aux professeurs non spécialistes en programmation ou en ergonomie, disposant de ressources temporelles et humaines limitées. Nous nous sommes limités aux 83 simulations destinées à l'enseignement des sciences aux niveaux secondaire, collégial et universitaire, disponibles sur Internet. Nous présentons enfin deux études de cas : la première pour l'évaluation de 64 simulations en mécanique newtonienne et la seconde pour l'évaluation de 19 simulations en thermodynamique.

Mots-clés : évaluation, simulations éducatives, grille, enseignement des sciences.

Introduction

Les apports des technologies de l'information et des communications en enseignement sont multiples ; Des différentes recherches (Bisdikian et Psillos, 2002 ; Zacharia, 2003) ont mis en évidence les apports de certains types d'utilisation des TIC (saisie et traitement automatique des données) et proposent des modalités d'intégration d'autres types (simulations) dans des démarches qui apparaissent particulièrement productives en termes d'activité cognitive des élèves.

Dans le cadre des disciplines d'enseignement scientifique telles que la physique, la simulation informatique demeure une ressource explicite et se présente comme un outil didactique puissant que l'enseignement des sciences doit en tirer profit. Cependant, il semble que les enseignants disposent peu d'aide pour évaluer et analyser de tels outils et que les résultats ne soient pas toujours à la hauteur des attentes espérés. Dans ce travail, nous tentons tout d'abord à rappeler les apports de l'usage des simulations informatiques en enseignement des sciences. Puis nous nous orientons vers la problématique du choix d'une simulation pour une situation d'apprentissage donnée. Après avoir traité les différents travaux de recherche concernant l'élaboration des critères de qualité des simulations éducatives, nous proposons une grille susceptible d'aider les enseignants à choisir la simulation adéquate pour une activité d'apprentissage qu'ils souhaitent exploiter avec les élèves. Enfin, nous présentons deux études de cas : la première en apprentissage de la mécanique et la deuxième en apprentissage de la thermodynamique.

1. Simulations en enseignement des sciences

Dans une vision constructiviste d'apprentissage utilisant les technologies de l'information et des communications, les outils les plus intéressants sont certainement les simulations (Jonassen, Peck & Wilson, 1999), dont Gredler (2004) dresse la liste des principales caractéristiques :

« (a) an adequate model of the complex real-world situation with which the student interacts (referred to as fidelity or validity), (b) a defined role for each participant, with responsibilities and constraints, (c) a data-rich environment that permits students to execute a range of strategies, from targeted to "shotgun" decision making, and (d) feedback for participant actions in the form of changes in the problem or situation. » (Gredler, 2004).

Le but d'une simulation est de permettre à l'utilisateur de découvrir par lui-même les règles qui sous-tendent le système étudié, ce qui en fait des « outils pour penser » (Mindtools, voir Jonassen, Peck & Wilson, 1999) très efficaces d'un point de vue constructiviste :

« An educational simulation should not be the reproduction of a system given to students to digest, but rather given to them so that by exploration and manipulation they can "discover" the system's behavior. » (Winer & Vázquez-Abad, 1981).

Des diverses études ont montré que les simulations présentent de nombreux avantages en éducation, permettant, entre autres (Droui et El Hajjami, 2014) :

- Une représentation concrète des concepts, une application des concepts connus à des niveaux supérieurs ; la découverte de nouveaux concepts, de nouveaux modèles ;

- Une manipulation des objets virtuels (Perkins et Simmons, 1988) ;

- Le développement d'un esprit critique ;

- La mise en évidence d'un conflit cognitif (Osborne et Squires, 1987) ;

- Une simplification des systèmes réels étudiés ;

- Une articulation entre un phénomène concret et sa représentation abstraite ;

- Une amélioration de la compréhension conceptuelle (Alessi et Trollip, 1985 ; Windschitl et Andre,1998 ; Zietsman et Hewson, 1986 ; Droui et coll., 2009 ; 2010)

- L'activation et le développement des compétences procédurales de base (observer, mesurer communiquer, classer, prédire....) (Osborne et Squires, 1987) ;

- L'activation des compétences procédurales spécifiquement intégrée à la démarche scientifique (contrôler les variables, formuler des hypothèses, interpréter des données, expérimenter et de formuler des modèles...) (Roth et Roychoudhury, 1993)

- La visualisation des phénomènes et la multiplication des formes de représentation (Richoux et coll., 2002 ; Sadler et al., 1999).

- La simulation se présente également comme :

- Une alternative aux expérimentations inaccessibles (Strauss et coll., 1994) ;

- Outil d'investigation scientifique et support pour le développement d'une habileté à enquêter (Windschitl, 2000) ;

- Outil de résolution des problèmes (Howse, 1998 ; Droui et al., 2013) ;

- Outil complémentaire aux expériences réelles ;

- Support d'un apprentissage individualisé et adapté au besoin.

2. Critères ergonomiques de sélection des simulations

Puisque nous nous adressons à des enseignants non spécialistes en utilisabilité, qui ont de fortes contraintes de temps et ne peuvent se permettre de suivre des normes de conception complexes, ou de mener des tests d'utilisabilité. Nous avons choisi d'examiner plus particulièrement les lignes directrices, critères, recommandations, et évaluations heuristiques, plus simples à manipuler. Des travaux de recherche en ergonomie se sont particulièrement intéressés aux critères (Bastien et Scapin, 1993), aux heuristiques (Nielsen, 1994), et la méthode d'évaluation de Ravden (Ravden et Johnson, 1989). À partir des trois ouvrages, Coutant (2008) a établi la liste des critères suivantes :

a) La pertinence et l'exactitude du contenu :

- Pertinence : le contenu scientifique abordé est pertinent, répond à une nécessité

- Exactitude : le contenu scientifique abordé est valide

b) La qualité de l'interface qui peut être caractérisée par les éléments suivants :

- Lisibilité

- Interface aérée : il y a suffisamment d'espace entre les éléments de l'interface

- Texte lisible : la typographie est claire, de taille suffisante, les majuscules et les minuscules sont utilisées

- Objets visibles : les objets et les textes contrastent suffisamment avec l'arrière plan

- Sobriété : un nombre limité et réfléchi de couleurs significatives (4-6 typiquement au maximum) et de fontes (2-3 typiquement au maximum) est utilisé

- Structure

- Séparation en zones : les objets apparentés sont regroupés et les objets ayant des fonctions différentes sont séparés.

- Structure logique : le découpage de l'interface suit la logique du cheminement de l'apprenant

- Lien symboles-contrôleurs-objets : les symboles, les paramètres et les objets associés ont un comportement / couleur / taille / typographie similaires ou un lien

- Contrôle

- Clarté des entrées explicite : les unités et les valeurs des entrées sont indiquées

- Contrôle sur les entrées explicite : les entrées de l'utilisateur sont explicitement validées et restent visibles après validation

- Contrôle sur le déroulement : l'état de la simulation est toujours indiqué, et l'utilisateur peu arrêter la simulation à tout moment

- Réponse rapide : la plupart des actions de l'utilisateur ont une réponse instantanée, de l'ordre du dixième de secondes

- Charge de travail

- Zone d'attention évidente : l'attention n'est pas perturbée par des animations, clignotement, éléments très colorés ou agressifs non pertinents

- Charge perceptive faible : il n'y a que les informations essentielles à l'écran, celles non nécessaires pouvant entre masquées

- Temps de navigation faible : le nombre de clics pour exécuter une action typique est faible (2-3 maximum)

- Transformations d'informations : les données affichées ne demandent pas de calculs ou de conversion de la part de l'utilisateur

- Compatibilité des symboles : le langage des messages est celui de l'utilisateur, selon son point de vue

- Compatibilité des actions : les interactions utilisées sont compatibles avec les habitudes et attentes des utilisateurs.

- Aide et gestion des erreurs

- Présence d'une aide : des instructions communes sont offertes de manière claire et concise

- Protection contre les erreurs : les erreurs communes sont détectées et n'altèrent pas le fonctionnement

- Correction des erreurs : les erreurs détectées peuvent être corrigées aisément

c) Pertinence de l'utilisation de la technologie

- Utilisation de la technologie : la simulation tire profit du multimédia (animations, sons), de possibilités d'interactions

- Utilité de la technologie : le même contenu n'aurait pas pu être traité aussi bien avec une méthode traditionnelle.

d) Critères techniques

- Catalogage : la simulation est accompagnée d'une description complète

- Portabilité : la simulation fonctionne sur toutes les plates-formes, tous les navigateurs

- Facilité d'installation : la simulation ne nécessite pas de connaissances sur les techniques requises pour l'installation

- Chargement court : le chargement n'excède pas 10 secondes

- Interactions accessibles : les modes d'interaction ne nécessitent pas d'habiletés particulières

- Performances : les performances de la simulation sont bonnes et constantes

3. Élaboration et validation d'une grille d'évaluation

La grille a été développée en vue d'aider les enseignants à choisir la simulation adéquate pour une activité d'apprentissage qu'ils souhaitent exploiter avec leurs élèves (voir annexe). La grille a été élaboré en se basant sur une revue de littérature exhaustive de la littérature y compris sur les apports des simulations éducatives en enseignement de la physique, des études sur les critères de qualité des simulations et des études de validation d'une grille (Loeken et al., 1996).

L'ensemble de ces documents a permis aux chercheurs de retenir 25 items considérés comme des critères ergonomiques et pédagogiques de choix des simulations éducatives. Le document préparé a été ensuite révisé par un groupe d'experts en didactique des sciences et en TICE. Une échelle de 0 à 2 a été retenue comme choix de réponse. La réponse 2 correspondait au plus haut niveau d'accord avec l'énoncé de l'item alors que la réponse 0 correspondait au niveau de désaccord.

Nous avons ensuite vérifié la validation de la grille en procédant à vérifier l'acceptabilité de la grille, la validité de son construit et sa fiabilité.

Le test d'acceptabilité de la grille a été réalisé auprès d'un groupe de 5 experts avec un échantillon de 20 simulations. Le critère de 3 % de données manquantes a été utilisé pour juger d'un potentiel problème d'acceptabilité (Fayers et Machin, 2000). Dans notre cas, toutes observations ont été retenues. Cela implique qu'il n'y avait aucune valeur manquante dans la base de données. Les entretiens qualitatifs conduits ont permis de s'assurer également de la validité de contenu du questionnaire.

La fiabilité de la grille a été évaluée en mesurant la consistance interne, qui traduit la façon dont les items d'une même échelle sont reliés, a été évalué à l'aide du coefficient alpha de Cronbach. Un coefficient alpha de Cronbach supérieur à 0,70 permettait de conclure une bonne consistance interne des échelles (Fayers et Machin, 2000). Le tableau 1 indique la valeur de l'indice alpha de Cronbach (0,87). Nous remarquons ici qu'elle dépasse le seuil minimum requis (0,70). Par conséquent, nous pouvons dire que nous avons, pour cette échelle composée de 25 éléments, une cohérence interne satisfaisante.

|

Tableau1. Statistiques de fiabilité |

|

Alpha de Cronbach |

Alpha de Cronbach basé sur des éléments normalisés |

Nombre d'éléments |

|

0,870 |

0,875 |

25 |

La validité de convergence et discriminante des échelles a été évaluée à l'aide des corrélations de Pearson (Fayers et Machin, 2000). Pour chaque corrélation supérieure à 0,4, on concluait à une bonne validité de convergence. Dans notre cas, presque tous les éléments sont suffisamment corrélés (r>0,4) pour que nous considérions qu'ils mesurent un même construit. Cela confirme donc le résultat présenté dans le tableau1.

4. Deux études de cas

4.1. Étude 1 : Simulations informatiques en mécanique

Dans cette étude, nous nous sommes limités aux simulations destinées à l'enseignement de la mécanique au niveau secondaire qui sont gratuitement disponibles sur Internet. Durant la recherche, nous avons utilisé les moteurs de recherche publics sur Internet à l'aide des mots clés comme « applet », « simulation », « Learning », etc. Nous estimons avoir accès à plus de 100 simulations qui se trouvent dans des sites crées par des professeurs et dans des diverses bibliothèques. Nous avons pu constater qu'une grande partie des liens regroupés dans de nombreux sites sont révélés invalides. Mais grâce à ces pages, nous avons encore de nombreux sites qui n'étaient pas référenciés sur Internet. Nous avons ensuite appliqué à 64 simulations sélectionnées, la grille (voir annexe) que nous avons élaboré à partir des différents critères de qualité adopté par Coutant (2008) en s'inspirant des travaux de Bastien et Scapin (1993), Nielson (1994) et Ravden et Johnson (1989) d'une part, et à partir d'une revue de littérature sur les apports et les avantages de l'usage des simulations en enseignement. Nous avons ainsi classé les différentes simulations selon le score moyen obtenu.

|

Tableau 2. Statistiques descriptives du score total |

|

Nbre total |

Moyenne |

Médiane |

Variance |

Écart-type |

Minimum |

Maximum |

|

64,00 |

32,86 |

33,00 |

62,03 |

7,88 |

20,00 |

46,00 |

Les analyses statistiques (tableau 3) montrent que la valeur moyenne de la variable score total de l'ordre de 32,86. Nous remarquons également que 32 simulations (presque 50 %) ont obtenu un score supérieur à la valeur 33,00. La valeur minimale est 20 points tandis que la valeur maximale est 46 points. Pour vérifier la normalité de la distribution de la variable "Score total", nous avons procédé aux tests de normalité.

|

Tableau 3. Tests de normalité de la variable score total |

|

Kolmogorov-Smirnov |

Kolmogorov-Wild |

|

Statistique |

ddl |

Signification |

Statistique |

ddl |

Signification |

|

0,188 |

64 |

0 |

0,914 |

64 |

0 |

Le tableau 3 montre les résultats des deux tests de normalité de Kolmogorov-Smirnov et de Shapiro-Wilk sont hautement significatifs avec une probabilité de signification pratiquement nulle (p<0.05). La figure 1 représente les histogrammes des scores attribués aux simulations évaluées. Nous enregistrons deux simulations avec un score de 46 points.

Figure 1. Histogramme des effectifs.

Les vingt premières simulations, qui ont obtenus les meilleurs scores, sont celles qui se trouvent sur le site de Physics educationnal technology de l'université de Colorado aux États-Unis (Phet, 2014). Nous portons, dans ce qui suit, une attention particulière à ces simulations. Le projet PhET met à la disposition des enseignants et des élèves plus de 80 simulations informatiques en différentes matières scientifiques (physique, mathématiques...). Ces simulations sont présentées sous formes d'outils d'apprentissage. Elles nous offrent la possibilité de les adapter à notre contexte et elles peuvent être présentées avec plusieurs langues. Elles sont disponibles gratuitement et largement utilisées à travers tout le monde. Les simulations PhET sont fondées sur des principes établis d'apprentissage et sur la recherche en éducation ; en effet plus de 250 entretiens avec des élèves utilisant les simulations et des études de recherche à grande échelle ont contribué à la base des simulations PhET (Wieman et al., 2008). Les simulations sont conçues pour être hautement interactives et pour promouvoir l'apprentissage des élèves par exploration des concepts et des phénomènes scientifiques (Adams et al., 2008)

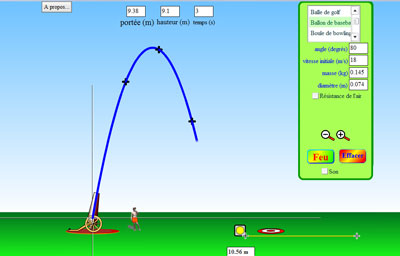

Figure 2. Illustration d'un exemple de simulations Phet (2014).

La figure 2 montre une illustration d'un exemple de simulation Phet (2014). Dans cette simulation, l'élève peut étudier le mouvement d'un projectile en modifiant les variables comme l'angle de tir, la vitesse initiale, la masse du projectile et visualiser les résultats de ses actions. Elle peut être utilisée avec plusieurs stratégies d'apprentissage : modélisation scientifique, investigation, résolution de problèmes... Ces simulations offrent également aux élèves l'opportunité de vérifier leurs hypothèses et de faire des expériences virtuelles.

4.2. Étude 2 : Simulations informatiques en thermodynamique

Dans cette étude, nous portons une attention particulière aux simulations destinées à l'enseignement de la thermodynamique qui sont gratuitement disponibles sur Internet. Et comme dans la première étude, nous avons utilisé les moteurs de recherche publics sur Internet à l'aide des mots clés comme « applet », « simulation »", « Learning », etc. Nous avons procéder à une quarantaine de simulations tandis qu'on n'a pu exploiter que 19 d'entre elles, les simulations restantes sont révélés invalides. Après l'application de la grille (annexe), nous avons classé les simulations valides selon le score moyen obtenu.

|

Tableau 4. Statistiques descriptives du score total |

|

Nbre total |

Moyenne |

Médiane |

Variance |

Écart-type |

Minimum |

Maximum |

|

19,00 |

28,21 |

28,00 |

76,40 |

8,74 |

13,00 |

42,00 |

Le tableau 4 montre que la valeur moyenne de la variable score total de l'ordre de 28,21. Nous remarquons aussi que 9 simulations (presque 50 %) ont obtenu un score supérieur à la valeur 28,00. Le score minimal est de 13 points tandis que le score maximal est de 42 points.

La figure 3 représente les histogrammes des scores attribués aux simulations évaluées. Nous enregistrons deux simulations avec un score de 42 points.

Figure 3. Histogramme des effectifs

Les sept premières simulations, qui ont obtenus les meilleurs scores, sont celles qui se trouvent sur le site de Physics educationnal technology de l'université de Colorado aux États-Unis (Phet, 2014) tout comme la première étude, cela reflète la grande qualité des ces simulations et aussi renforce également la validité de notre grille. Les deux premières simulations qui ont eu le score maximal sont : « l'état de la matière » (Phet, 2014) et « réaction et cinétique »(Phet, 2014)

|

|

|

|

|

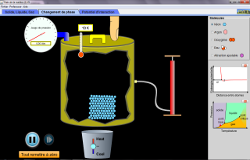

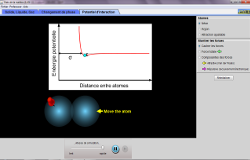

Figure 4. Illustration d'un exemple de simulations Phet (2014) « État de la matière ». |

La figure 4 illustre la simulation « l'état de la matière », présentée sous forme d'onglets en haut :

Dans le premier onglet, on peut basculer entre différents produits chimiques, l'état de la matière peut être aussi changé et la température est ajustée de façon réaliste en fonction de ces choix. Dans le deuxième onglet, on peut basculer entre différents produits chimiques, ajouter plus d'atomes, diminuer le volume de la paroi, changer la température en chauffant la matière, la pression et la température s'affichent ainsi de façon réaliste. Plus encore, le diagramme de phase et le potentiel d'intégration entre atomes peut être affiché à tout moment. Dans le troisième onglet, on peut basculer entre deux types d'atomes ou ajuster l'attraction selon le diamètre atomique et la profondeur du puit de potentiel.

Le point fort de ces simulations est qu'elles sont exploitables dans différentes situations d'apprentissage, aussi peuvent être introduite dans diverses stratégies d'apprentissage.

Conclusion

Dans ce travail, nous avons présenté une méthode de conception et de validation d'une grille, destinée aux enseignants disposant de ressources temporelles et humaines limitées dans le but de les aider à choisir la simulation adéquate pour une activité d'apprentissage qu'ils souhaitent entreprendre avec leurs élèves. Nous nous sommes inspirés d'une revue de littérature sur les apports des usages des simulations informatiques en enseignement des sciences et sur les différents travaux de recherche concernant l'élaboration des critères de qualité des simulations. Nous avons tenté d'explorer cette grille avec deux études de cas : la première pour l'évaluation de 64 simulations en mécanique newtonienne et la seconde pour l'évaluation de 19 simulations en thermodynamique. Les résultats de cette étude sont encourageants et montrent que la grille se présente comme support utile aux enseignants pour sélectionner la simulation la plus adéquate.

Mohamed Droui 1, 2, 3, 4,

Abdelkrim El Hajjami 1, 2,

Abdelouahab Benali Amjoud 1, 2

Cet article est sous licence Creative Commons (selon la juridiction française = Paternité - Pas de Modification).

http://creativecommons.org/licenses/by-nd/2.0/fr/

1. Laboratoire « Technologies de l'Information et de la Communication pour la Formation en Sciences », École Normale Supérieure-Fès, Maroc.

2. Laboratoire Interdisciplinaire de Recherches en Didactique des Sciences et Techniques (LIRDIST). Faculté des sciences Dhar El Mahraz- Fès, Maroc.

3. LaREF-EST, Université Mohammed Premier – Oujda, Maroc.

4. Université de Montréal / Canada et Mati-Montréal /Canada.

Références bibliographies

Adams, W. K., Reid, S., LeMaster, R., McKagan, S., Perkins, K., Dubson, M., Wieman, C.E. (2008). A Study of Educational Simulations Part II – Interface Design. Journal of Interactive Learning Research, 19(4), 551-577.

Alessi, S. M. &. Trolip S. R (1985), Computer-Based Instruction : Methods and Development. Englewood Cliffs, New Jersey : Prentice-Hall, Inc.

Bastien, J. M. C., Scapin, D. (1993). Ergonomic Criteria for the Evaluation of Human-Computer interfaces. Institut National de recherche en informatique et en automatique, France.

Bisdikian, G. et Psillos, D. (2002). Enhancing the linking of theoretical knowledge to physical phenomena by real-time graphing. In D. Psillos et H. Niedderer (Eds) Teaching and learning in the science laboratory (Dordrecht : Kluwer), p. 193-204.

Coutant, F (2008). Analyse, correction et évaluation de simulations éducatives pour l'enseignement des sciences. Mémoire de maîtrise à l'École polytechnique de Montréal (163 pages).

Droui, M. El Hajjami, A. Bouklah, M. Zouirech, S. (2013). « Impact de l'apprentissage par problème sur la compréhension conceptuelle de la mécanique newtonienne ». Revue EpiNet, n° 157, septembre 2013.

http://www.epi.asso.fr/revue/articles/a1309d.htm

Droui, M. EL Hajjami, A (2014) « Simulations informatiques en enseignement des sciences : apports et limites ». Revue EpiNet, n° 164, avril 2014.

http://www.epi.asso.fr/revue/articles/a1404e.htm

Droui, M., Martial, O., Kébreau, S., Pierre, S. et Vázquez-Abad, J. (2009). « Les technologies mobiles pour mieux comprendre l'apprentissage coopératif dans un cours de physique », dans Utilisation des technologies pour la recherche sur l'éducation scientifique sous la direction de M. Riopel, P. Potvin et J. Vázquez-Abad, Les Presses de l'Université Laval, Chapitre 4, p. 79-110.

Droui, M., Martial, O., Kébreau S., Pierre S., Vazquez-Abad, J. (2010). Les TICE pour un apprentissage collaboratif : simulation et technologies mobiles pour explorer le modèle quantique de la lumière. Actes du 26e congrès de l'Association Internationale de Pédagogie Universitaire, AIPU 2010 (17-21 mai 2010, Rabat), Maroc.

Fayers,P. Machin,D. (2000). Quality of Life : Assessment, Analysis, and Interpretation . New York : John Wiley.

Gredler, M. (2004). Games and simulations and their relationships to Learning. In D. H. Jonassen (Ed.), Handbook of research for educational communications and technology (2nd edition)., Mahwah (NJ) : Laurence Erlbaum Associates, p. 571-581.

Howse, M. A. (1998). Student ecosystems problem solving using computer simulation. Washington D.C. : Office of Educational Research and Improvement, (ERIC Document Reprodu tion Service No ED419679).

Jonassen, D. H., Peck K. L. & Wilson, B. G. (1999). Learning With Technology : A Constructivist Perspective. New Jersey : Merril. p. 2-11.

Loeken, K., Steine, S., Sandvik, L., Laerum, E., Finset, A. (1996). A new measure of patient satisfaction with mammography. Validation by factor analytic technique. Fam Pract, 13 : 67-74.

Nielsen, J. (1994). Heuristic evaluation. In J., Nielsen and R.L. Mack (Eds.), Usability Inspection Methods. John Wiley & Sons, New York.

Osborne, J. & D. Squires (1987). « Learning science through experiential software ». In J. Novak (Ed.), Proceedings of the Second International Seminar on Misconceptions and Educational Strategies in Science and Mathematics, Vol. 1, Ithaca, NY : Cornell University, p. 373–380.

Perkins, D.N. & Simmons, R. (1988). Patterns of misunderstanding : An integrative model for science, math, and programming. Review of Educational Research, 58, p. 303–326.

PhET (Physicis Education Technology) (2014). Disponible à l'adresse :

http://phet.colorado.edu/new/simulations (Consulté le 28 mai 2014).

Ravden, J Susannah, Johnson, I Graham (1989). Evaluating Usability of Human-Computer Interfaces : A Practical Method. Chichester : Ellis Horwood (John Wiley & Sons).

Richoux, B., Salvetat, C. & Beauils, D. (2002). Simulation numérique dans l'enseignement de la physique : enjeux, conditions, Bulletin de l'Union des Physiciens, n° 842, p. 497-522.

Roth, W. M. et A. Roychoudhury (1993). The development of science process skill in authentic context. Journal of Research in Science Teaching, 30, p. 127-152.

Sadler, P. M., Whitney, C. A., Shore, L. & Deutsch, F. (1999). Visualization and Representation of Physical Systems : Wavemaker as an Aid to Conceptualizing Wave Phenomena. Journal of Science Education and Technology, 8, p. 197-209.

Strauss, R.T. & Kinzie, M. B. (1994). Student achievement and attitudes in a pilot study comparing an interactive videodisc simulation to conventional dissection. The American Biology Teacher 56(7), p. 398-402.

Windschitl, M. (2000), Supporting the development of science inquiry skills with special classes of software. Educational Technology Research & Development, 48, p. 81 95.

Windschitl, M. & T. Andre (1998), Using computer simulations to enhance conceptual change : The roles of constructivist instruction and student epistemological beliefs. J. of Research in Science Teaching, 35(2), p. 145-160.

Winer, Laura R. ; Vazquez-Abad, J. (1981). Towards a Theoretical Framework for Educational Simulations. Simulation/Games for Learning, v. 11, n 3, p. 114-19 Fall.

Zacharia, Z. (2003). Beliefs, attitudes and intentions of science teachers regarding the educational use of computer simulations and inquiry-based experiments in physics. Journal of Research in Science Teaching, 40(8), p. 792-823.

Zietsman, A. I., and P. W. Hewson (1986), Effects of instruction using microcomputer simulations and conceptual change learning strategies in science learning, Journal of Research in Science Teaching, vol. 23, p. 27-39.

Annexe : Grille de sélection des simulations

|

item |

|

0 |

1 |

2 |

|

Critères ergonomiques |

|

1 |

Lisibilité : Interface aérée, Objets visibles, Sobriété (couleurs, fontes) |

|

|

|

|

2 |

Structure de l'interface : Séparation en zones, Structure logique, Lien symboles-contrôleurs-objets |

|

|

|

|

3 |

Contrôle : Clarté des entrées explicite, Contrôle sur les entrées explicite, Contrôle sur le déroulement, Réponse rapide |

|

|

|

|

4 |

Charge de travail : Zone d'attention évidente : Charge perceptive faible, Temps de navigation faible : Transformations d'informations, Compatibilité des symboles et des actions |

|

|

|

|

5 |

Aide et gestion des erreurs : Présence d'une aide, Protection contre les erreurs, Correction des erreurs. |

|

|

|

|

6 |

la simulation est accompagnée d'une description complète et les modes d'interaction ne nécessitent pas d'habiletés particulières |

|

|

|

|

7 |

la simulation fonctionne sur toutes les plateformes, tous les navigateurs, elle ne nécessite pas de connaissances sur les technologies employés ni d'installation |

|

|

|

|

8 |

les performances de la simulation sont bonnes et constantes et le chargement n'excède pas 10 secondes |

|

|

|

|

9 |

le contenu scientifique abordé est pertinent, répond à une nécessité |

|

|

|

|

10 |

le contenu scientifique abordé est valide |

|

|

|

|

Critères pédagogiques |

| |

La simulation permet : |

|

11 |

Une représentation concrète des concepts, une application des concepts connus à des niveaux supérieurs ; la découverte de nouveaux concepts, de nouveaux modèles |

|

|

|

|

12 |

Une manipulation des objets virtuels |

|

|

|

|

13 |

Le développement d'un esprit critique |

|

|

|

|

14 |

La mise en évidence d'un conflit cognitif |

|

|

|

|

15 |

Une simplification des systèmes réels étudiés |

|

|

|

|

16 |

Une articulation entre un phénomène concret et sa représentation abstraite |

|

|

|

|

17 |

Une amélioration de la compréhension conceptuelle |

|

|

|

|

18 |

L'activation et le développent des compétences les compétences procédurales de base (observer, mesurer communiquer, classer, prédire...) |

|

|

|

|

19 |

L'activation des compétences procédurales spécifiquement intégrée à la démarche scientifique (contrôler les variables, formuler des hypothèses, interpréter des données, expérimenter et de formuler des modèles...) |

|

|

|

|

20 |

La visualisation des phénomènes et la multiplication des formes de représentation |

|

|

|

| |

La simulation se présente comme : |

|

21 |

Une alternative aux expérimentations inaccessibles |

|

|

|

|

22 |

Outil d'investigation scientifique et pour le développement d'une habileté à enquêter |

|

|

|

|

23 |

Outil de résolution des problèmes |

|

|

|

|

24 |

Outil complémentaire aux expériences réelles |

|

|

|

|

25 |

Support d'un apprentissage individualisé et adapté au besoin |

|

|

|

|